SEO продвижение сайтов в Казани

Мало заявок? Не идут клиенты?

Закажите у нас комплексную оптимизацию вашего сайта!

Выведем в ТОП-10 Яндекса и Google

Студия CITYNIX — это один из ключевых игроков seo-продвижения на региональном рынке. Занимаемся SEO-продвижением сайтов в Казани более 10 лет. Поможем вам привлечь новых клиентов и продвинем сайт на первые позиции Yandex и Google за 6 месяцев. Первые плоды продвижения вы заметите уже через 3 месяца — число заявок вырастет на 30%, трафик на сайт — на 350%.

Что позволит сделать SEO-продвижение:

- Увеличить прибыль.

- Повысить продающие способности сайта.

- Повысить репутацию компании.

- Расширить клиентскую базу.

- Повысить узнаваемость бренда.

Почему доверить нам создание и продвижение сайтов — отличное решение:

Почему доверить нам создание и продвижение сайтов — отличное решение:

Мы предлагаем комплексные услуги по созданию и продвижению сайтов, помогая бизнесам успешно представить себя в интернете и привлечь больше клиентов. Создание сайта — это первая часть работ, он не приведет сразу поток клиентов. SEO продвижение сайта обеспечивает приток новых клиентов из поиска. За качественным СЕО в Казани обращайтесь к нам, и вот почему:

Поисковое продвижение сайта белыми методами

Поисковое продвижение сайта поможет улучшить его позиции в результатах поиска, повысить трафик и привлечь целевую аудиторию. В нашем портфолио множество успешных кейсов продвижения сайтов в поисковой системе. Мы используем только «белые» методы SEO-продвижения сайта в топ. Проводим как внутреннюю, так и внешнюю оптимизацию веб-страниц. Продвижение сайта в поисковой системе является неотъемлемой частью его успешной онлайн-стратегии, обеспечивая улучшение видимости и привлечение большего количества клиентов.

Работаем с контентом сами

Тщательно изучаем услуги вашей компании, анализируем сайты-конкурентов. В процессе SEO-продвижения проекта мы проводим СЕО оптимизацию уже существующих текстов и каталога товаров, а также создаем и наполняем сайта контентом.

Улучшаем юзабилити сайта

Кроме раскрутки сайта мы оптимизируем структуру сайта, улучшаем его внешний вид и удобство для потенциальных клиентов. В круг наших задач входит создание и усовершенствование мобильной версии вашего сайта.

Внимательно относимся к клиентам

У нас большой опыт в работе с кейсами по SEO-продвижению сайтов в Казани. Нас отличает индивидуальный и креативный подход к каждому проекту. Мы стремимся к максимально эффективному и долгосрочному сотрудничеству с клиентами и предлагаем оптимальные цены на SEO продвижение. Заказать СЕО продвижение сайта в Казани можно на сайте

Цена на СЕО продвижение сайтов в Казани

| Крупные города | 35 000 ₽ |

| Москва | 50 000 ₽ |

| Региональные сайты | 25 000 ₽ |

| Федеральные проекты | 60 000 ₽ |

Цена продвижения сайта зависит от множества факторов, включая объем работ, выбранные стратегии и конкурентность рынка. В современном цифровом мире успешное продвижение сайтов играет важную роль в развитии бизнеса. Стремительное развитие технологий и все более углубляющаяся цифровизация общества делают присутствие в интернете необходимостью для любой компании. Однако, чтобы сайт был эффективным инструментом, необходимо обеспечить его высокую видимость в поисковых системах. Рассмотрим ключевые аспекты SEO продвижения, которые способствуют успешной интернет-раскрутке.

SEO-аудит как ключевой этап успешного продвижения

Процесс продвижения сайтов в современных реалиях требует системного подхода и стратегического планирования. Одним из ключевых этапов этой стратегии является SEO-аудит, который имеет особое значение для успешного продвижения в региональных контекстах, таких как в Казани. Давайте рассмотрим, почему SEO-аудит стоит считать отправной точкой для эффективного продвижения сайта в этом регионе.

Что такое SEO-аудит и как он помогает в продвижении сайтов?

SEO-аудит представляет собой подробный анализ веб-ресурса с целью выявления текущего состояния сайта и его слабых сторон, которые могут оказывать влияние на его видимость в поисковых системах. В контексте продвижения сайтов в Казани, этот этап становится еще более значимым, так как местные запросы и предпочтения аудитории могут иметь свои особенности.

Основные аспекты SEO-аудита для продвижения сайтов

- Анализ ключевых слов

Для успешного продвижения сайта в регионе важно знать, какие ключевые слова и фразы используют потенциальные клиенты в Казани. Определение наиболее релевантных ключевых слов позволит оптимизировать контент сайта и адаптировать его под местные запросы. - Сравнение с конкурентами

Анализ деятельности конкурентов в Казани поможет понять, какие стратегии успешно работают в данном регионе. Это может дать ценные идеи для улучшения своей стратегии продвижения. - Оценка технических аспектов

Скорость загрузки страниц, адаптивность под разные устройства, исправность ссылок — все эти технические аспекты важны как для общей видимости сайта, так и для удовлетворения запросов пользователей в Казани. - Географическая оптимизация

Для продвижения в Казани важно настроить географическую оптимизацию. Использование геотегов, добавление информации о местоположении на страницах сайта — все это помогает сайту стать более релевантным для местных пользователей.

SEO-аудит является неотъемлемой частью стратегии успешного продвижения сайтов в Казани. Он позволяет выявить слабые места и потенциал для улучшения, особенно в контексте местных запросов и конкурентной среды. Подготовленный на основе результатов аудита план действий становится надежной основой для разработки дальнейшей стратегии продвижения, которая будет нацелена на максимальную эффективность в регионе, таком как в Казани.

Контент-маркетинг и SEO

Продвижение сайтов в Казани — это не только техническая оптимизация, но и стратегическое использование контент-маркетинга. Эффективное взаимодействие этих двух подходов может значительно усилить результаты SEO продвижения. Давайте рассмотрим, почему контент-маркетинг является важной составляющей SEO оптимизации, особенно в контексте в Казани.

Значение контент-маркетинга для SEO продвижения в Казани

- Уникальность и релевантность Контента

Создание уникальных и интересных материалов, ориентированных на местную аудиторию, позволяет вашему сайту выделиться среди конкурентов. Это повышает его релевантность для пользователей и, следовательно, может улучшить его позиции в поисковых результатах. - Ключевые слова и местные запросы

Контент-маркетинг позволяет интегрировать ключевые слова и фразы, характерные для в Казани, в описания, статьи и другие материалы. Таким образом, ваш сайт становится более релевантным для местных пользователей, которые активно ищут услуги и товары именно в этом регионе. - Регулярные обновления

Постоянное обновление контента поддерживает актуальность вашего сайта в глазах поисковых систем. Регулярные публикации статей, новостей или блогов позволяют удерживать внимание аудитории и повышать авторитет в релевантной области.

Советы для эффективного контент-маркетинга в Казани

- Локальная адаптация

Помимо использования ключевых слов, связанных с в Казани, стоит также обращать внимание на местные события, новости и интересы. Адаптируйте контент под местную аудиторию, чтобы вызвать больший отклик. - Местные истории и отзывы

Публикация историй успеха ваших клиентов в Казани или отзывов местных потребителей может значительно усилить доверие к вашей компании. - Интерактивность и участие

Проводите опросы, конкурсы или мероприятия, которые привлекут местную аудиторию. Это способствует активному участию пользователей и распространению вашего контента.

Контент-маркетинг — это мощное дополнение к технической SEO оптимизации при продвижении сайтов в Казани. Создание уникальных, релевантных и интересных материалов, а также активное взаимодействие с местной аудиторией, способствуют повышению видимости вашего сайта и укреплению позиций в региональном рынке, где в Казани играет важную роль.

Как оптимизация для местных запросов помогает бизнесам привлекать клиентов

В современной бизнес-среде, где конкуренция становится все более жесткой, продвижение сайта в местных поисковых запросах приобретает огромное значение. Для многих компаний, ориентированных на конкретные регионы, это становится важным аспектом их маркетинговой стратегии. Оптимизация сайта позволяет улучшить его позиции в поисковых системах и обеспечить более эффективное взаимодействие с аудиторией. Давайте рассмотрим, как оптимизация для местных запросов помогает бизнесам привлекать клиентов и какие ключевые моменты следует учитывать.

Преимущества оптимизации для местных запросов

- Целевая аудитория: оптимизация для местных запросов позволяет бизнесам акцентировать внимание на своей целевой аудитории в конкретном городе или регионе. Это позволяет привлечь клиентов, находящихся вблизи, которым требуются услуги и товары именно в этой локации.

- Уменьшение конкуренции: оптимизация для местных запросов уменьшает конкуренцию, так как вы соревнуетесь в более узком региональном контексте. Это дает вам больше шансов выделиться и занять лидирующие позиции в поисковых результатах.

- Локальное доверие: когда пользователи видят, что ваш бизнес находится в их регионе, это создает доверие. Люди часто предпочитают работать с местными компаниями, так как это дает им уверенность в качестве и надежности предоставляемых услуг.

Эффективные стратегии оптимизации для местных запросов

- Географические теги: используйте географические теги на страницах вашего сайта. Включите название города или региона в заголовки, подзаголовки и тексты. Это сигнализирует поисковым системам о вашей связи с определенным местоположением.

- Оптимизированные метаданные: важно оптимизировать метаданные вашего сайта, включая заголовки и описания страниц. Убедитесь, что они отражают контекст местных запросов.

- Создание локальных контактов: укажите на сайте актуальную информацию о местоположении, контактных данных и графике работы. Это помогает убедить пользователей, что вы действительно находитесь рядом.

- Отзывы и оценки: стремитесь получать отзывы от клиентов в вашем регионе. Положительные отзывы и высокие оценки укрепляют вашу репутацию среди местной аудитории.

Оптимизация для местных запросов — это мощная стратегия для бизнесов, ориентированных на определенный регион. Она позволяет эффективно привлекать клиентов, уменьшить конкуренцию и укрепить доверие в глазах пользователей. Путем использования географических тегов, оптимизированных метаданных и локальной информации, вы создаете более привлекательное онлайн-присутствие, способствующее успешному привлечению целевой аудитории.

Мы специализируемся в области интернет-продвижения сайтов, используя эффективные стратегии и инструменты для привлечения целевой аудитории и улучшения видимости вашего бизнеса. Эффективное SEO продвижение не только увеличивает трафик на сайт, но и улучшает пользовательский опыт, делая сайт более удобным и информативным для посетителей. Оптимизация контента, технические улучшения и работа с внешними ссылками — все эти компоненты совместно способствуют повышению рейтинга сайта и его привлекательности для поисковых систем.

Зачем нужно SEO-продвижение

SEO-продвижение (Search Engine Optimization) – это комплексная оптимизация сайта, направленная на улучшение его позиций в поисковой выдаче Яндекса и Google.

Что входит в SEO-продвижение:

- внутренняя оптимизация;

- внешняя оптимизация;

- ведение блога.

Продвижение помогает увеличить трафик сайта и количество заявок. Чем выше поднимается интернет-ресурс в ТОПе поисковиков, тем больше потенциальных клиентов его увидит. Перед началом работы с каждым сайтом проводится SEO-аудит, т.е. анализ интернет-ресурса, поиск ошибок. По итогам аудита разрабатывается стратегия продвижения.

План продвижения

Разрабатываем индивидуальную стратегию продвижения

Комплексный подход

Всегда учитываем множество факторов, которые могут повлиять на ранжирование страниц

Анализ конкурентов

Проводим маркетинговое исследование ваших конкурентов с сайтами в ТОП-10

Работа с целевой аудиторией

Исследуем все способы привлечения потенциальных клиентов

Официальный договор

Перед началом работы с новым клиентом заключаем договор и обговариваем все детали

Ежемесячная отчётность

Мы предоставляем отчёты по всем работам, проводимым на сайте, и значимым показателям

Только «белые» методы SEO

Мы действуем честно и открыто: ваш сайт никогда не попадёт в «бан»

Новые «фишки» продвижения

Оперативно реагируем на изменение алгоритмов поисковых систем

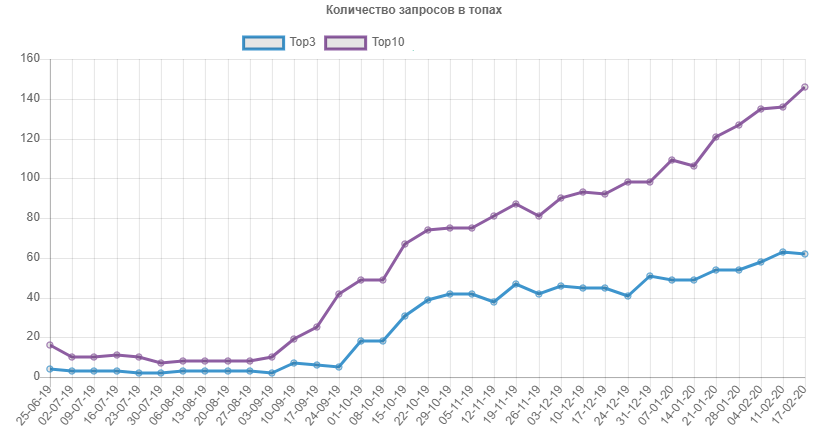

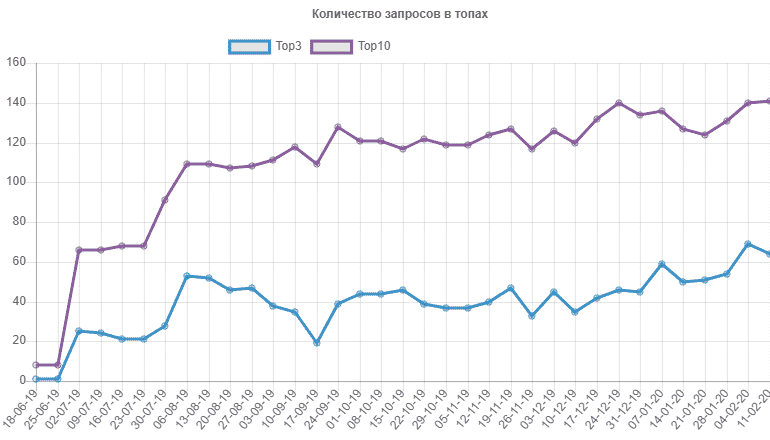

Реализованные кейсы

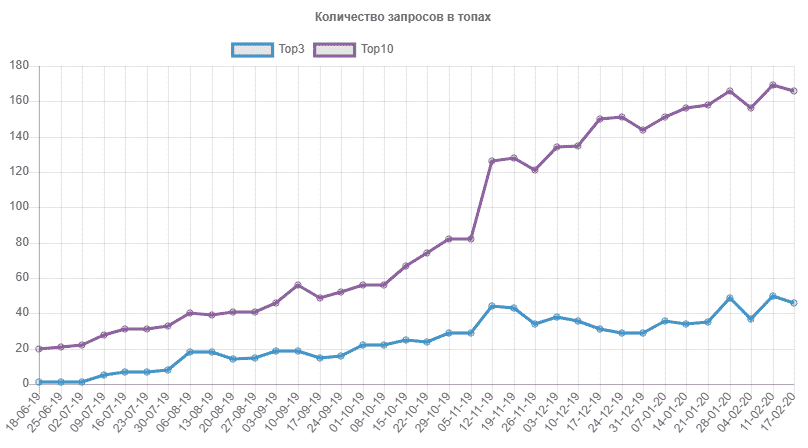

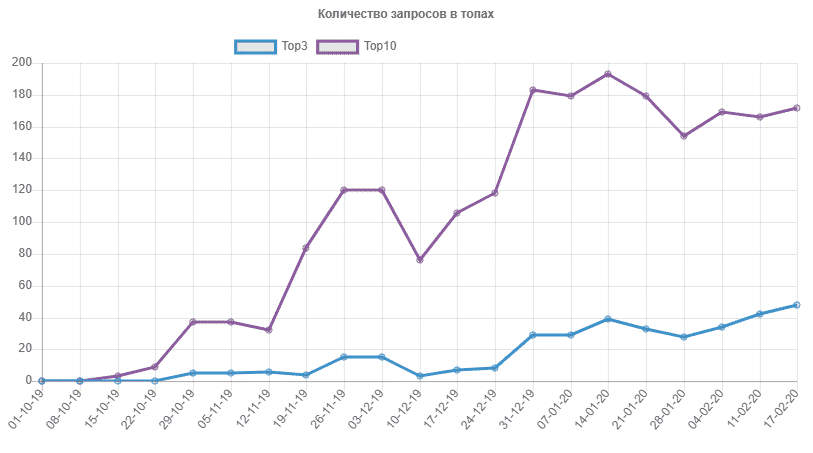

Как вывести сайт образовательного центра при вузе в ТОП-3 за 6 месяцев, Повысить трафик в 10 раз и получить лиды с информационных запросов.

Как вывести сайт с услугами грузчиков и грузоперевозок в ТОП-3 в выдаче Яндекса и Google, привлечь новых клиентов и увеличить количество заказов.

Как продвигать стоматологию в регионе по конкурентным запросам, вывести сайт в ТОП-10 за 5 месяцев и увеличить поток клиентов.

Как продвигать юридический центр по России, вывести сайт в ТОП-10 за 4 месяца, увеличить количество посетителей и клиентов.

Получите скидку 15% на месяц СЕО продвижения

SEO-продвижение (Search Engine Optimization) – это комплексная оптимизация сайта, направленная на улучшение его позиций в поисковой выдаче Яндекса и Google. Продвижение помогает увеличить трафик сайта и количество заявок.

Первые результаты работы становятся заметны не сразу. Особенно если речь идёт о новом сайте и высокочастотных ключевых запросах. Мы можем прогнозировать хороший результат через 3-4 месяца работы с вашим интернет-ресурсом, однако всё зависит от конкретного проекта.

Не стоит ждать от SEO-продвижения моментального увеличения продаж и огромного притока новых клиентов. Кроме того, специфика нашей работы не позволяет гарантировать то, что сайт вашей компании займёт первые места в ТОПе поисковиков.

SEO-продвижение следует проводить на постоянной основе. После завершения работы над проектом эффект сохраняется, но лишь на какое-то время: уже через несколько недель ваш сайт потеряет свои позиции и всё придётся начинать заново.

Как правило, на создание сайта с нуля у нас уходит от 30 до 45 дней. За этот период мы выполняем весь комплекс работ от разработки структуры под ваш бизнес и до наполнения сайта контентом. Точное время работы зависит от количества страниц и требуемого функционала.

Мы предоставляем своим клиентам ежемесячные отчёты о проделанной работе. Кроме того, при работе над каждым проектом мы создаём чат в мессенджере, где вы всегда можете задать свои вопросы и высказать пожелания.

Выражаю благодарность команде веб-студии «CITYNIX» за совместную реализацию ряда коммуникационных проектов.

Специалисты «CITYNIX» прекрасно справились с поставленными задачами исходя из технического задания по разработке веб-дизайна, а также по комплексной оптимизации сайта проекта, направленной на улучшение его позиций в поисковой выдаче.

Особо хочу отметить креативный подход команды веб-студии «CITYNIX» и умение работать в условиях сжатых сроков. Отдельно считаю важным отметить, сопровождение проекта: любые вопросы, которые у нас возникали по проекту, студия решила быстро и оперативно, мы полностью спокойны и уверены в результате.

Специалисты компании «Ситиникс» провели очень тщательную работу над нашим сайтом!

В кратчайшие сроки они разработали структуру и дизайн нашего корпоративного сайта, презентующего ключевые услуги компании. Через месяц после подписания договора мы получили рабочий, современный и стильный сайт, который идеально вписывается в цели нашей компании.

В ходе работы мы оценили высокий профессионализм сотрудников компании ООО «Ситиникс» и скорость выполнения задач. Правки вносились быстро и корректно, на всем протяжении нашего сотрудничества нас оперативно консультировали по всем возникшим вопросам.

Выражаем благодарность ООО «Ситиникс» за ответственный и добросовестный труд. За более чем 3 года сотрудничества мы убедились в том, что сотрудники компании «Ситиникс» успешно справляются с любыми задачами по продвижению и разработке сайтов. Следует отметить чёткое соблюдение сроков выполнения поставленных нами задач, высокую инициативность и отзывчивость в решении интересующих вопросов.

Компетентность и профессионализм сотрудников «Ситиникс» позволили нам использовать наш интернет ресурс как главный инструмент продаж. Надеемся и на дальнейшее плодотворное сотрудничество. Желаем больших успехов и достижений в работе!

Выражаем благодарность ООО «Ситиникс» за поисковую оптимизацию, обновление дизайна и продвижение сайта. Студия проявила себя как надежный и стабильный партнер на рынке услуг.

В течение года успешно сотрудничаем с ООО «Ситиникс»: сайт стабильно находится в ТОП-10 по ключевым запросам, все вопросы оперативно решаются, сотрудники компании постоянно на связи. Кроме того, компания предлагает полезные идеи по доработке сайта, и все это в рамках комфортного для нас бюджета.

Наша компания выражает признательность специалистам компании ООО «Ситиникс» за выполнение услуг по созданию, оптимизации и продвижению нашего сайта.

Хотим отметить эффективный и слаженный процесс работы. Четкие сроки выполнения задач, ежемесячная отчетность, грамотные консультации – все это делает процесс продвижения нашего сайта понятным и прозрачным.

Компания ООО «Ситиникс» занимаются продвижением нашего сайта уже несколько лет. Им удалось вывести множество целевых запросов в ТОП-10 поисковых систем, а количество посетителей нашего сайта постоянно ростет.

Мы считаем сотрудников «Ситиникс» профессионалами в сфере поискового продвижения и полностью доверяем их опыту.